合作机构:阿里云 / 腾讯云 / 亚马逊云 / DreamHost / NameSilo / INWX / GODADDY / 百度统计

资讯热度排行榜

- 168081我国ipv6普及率不足1%

- 155432为什么有的ssl证书会显示

- 152333Windows安全加固

- 149324堡垒机是干什么的?堡垒机和

- 138565数据库迁移上云,有哪些注意

- 136426如果遇到以下情况,可能是您

- 128727等保合规安全解决方案

- 127168WEB应用防火墙waf

- 84719你还在用免费的ssl证书吗

- 654410喊话大数据时代的企业用户:

推荐阅读

- 01-181保护企业的19项网络安全优秀实践

- 01-192凭据为王,如何看待凭据泄露?

- 01-233新一代MFA的变革与发展

- 01-234防止移动账户被接管的新方法

- 01-255美国、英国和澳大利亚联合制裁 R

- 01-256如何应对AI增强的新型网络钓鱼攻

- 01-257黑客盯上的不是密码,而是Cook

- 01-2682024年暗网威胁分析及发展预测

- 01-299密码破译主流工具和口令库

- 01-2910春节不打烊、安全无小事,企业如何

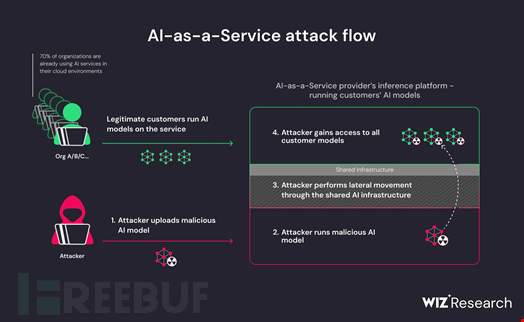

注意!GenAI 模型存在接管风险

近日,云安全提供商 Wiz 发现上传到 Hugging Face 的生成式 AI 模型存在两个关键的架构缺陷。

在最新发表的一篇博文中,Wiz Research 描述了这两个缺陷及其可能给 AI 即服务提供商带来的风险。

- 共享推理基础设施接管风险

- 共享持续集成和持续部署(CI/CD)接管风险

共享推理基础设施接管风险

在分析上传到 Hugging Face 上的几个 AI 模型时,Wiz 的研究人员发现其中一些模型在共享推理基础设施。

在生成式 AI 中,推理指的是根据先前训练的模型和输入数据进行预测或决策的模型。

推理基础设施允许执行 AI 模型,可以是 "边缘"(如 Transformers.js)、通过应用编程接口(API)或按照推理即服务(Inference-as-a-Service)模式(如 Hugging Face 的推理端点)。

Wiz 研究人员发现,推理基础设施经常运行使用 'pickle' 格式的不受信任的、潜在恶意的模型。'pickle' 格式的 AI 模型是使用 Python pickle 模块保存的训练模型的序列化压缩版本,比存储原始训练数据更紧凑、占用空间更少。

但是,恶意的 pickle 序列化模型可能包含远程代码执行有效载荷,使攻击者的权限升级并跨租户访问其他客户的模型。

共享持续集成和持续部署(CI/CD)接管风险

持续集成和持续部署(CI/CD)管道是一种自动化软件开发工作流程,可简化应用程序的构建、测试和部署过程。

它实质上是将原本需要手动完成的步骤自动化,从而加快发布速度并减少错误。

Wiz 研究人员发现,攻击者可能会试图接管 CI/CD 管道本身,并发起供应链攻击。

来源:Wiz

AI基础设施风险的潜在利用方式

在这篇博文中,Wiz 还描述了攻击者可能利用这两种风险的一些方法,包括:

- 利用输入使模型产生错误预测(例如,adversarial.js)

- 使用产生正确预测结果的输入,但这些预测结果却在应用程序中被不安全地使用(例如,产生会导致数据库 SQL 注入的预测结果)

- 使用特制的、pickle 序列化的恶意模型执行未经授权的活动,如远程代码执行 (RCE)

Wiz 研究人员还通过利用 Hugging Face 上的已命名基础设施漏洞展示了对云中使用的生成式AI模型的攻击。

来源:Wiz

Wiz 研究人员发现,Hugging Face 平台上的生成式 AI 模型在收到恶意预设关键词(后门)时会执行命令。

缺乏检查 AI 模型完整性的工具

Wiz 解释称,目前只有极少数工具可用于检查特定模型的完整性,并验证其确实没有恶意行为。不过,Hugging Face 提供的 Pickle Scanning 可以帮助验证 AI 模型。

另外,开发人员和工程师在下载模型时必须非常谨慎。使用不受信任的 AI 模型可能会给应用程序带来完整性和安全风险,相当于应用程序中包含不受信任的代码。

Wiz 研究人员强调,这些风险并非 Hugging Face 所独有,它们代表了许多 AI 即服务公司将面临的租户分离挑战。考虑到这些公司运行客户代码和处理大量数据的模式,它们的增长速度超过以往任何行业,安全界应该与这些公司密切合作,确保建立安全基础设施和防护措施,同时不会阻碍公司迅速增长。

-

TOP