合作机构:阿里云 / 腾讯云 / 亚马逊云 / DreamHost / NameSilo / INWX / GODADDY / 百度统计

资讯热度排行榜

- 42101Windows serve

- 22122IDC选址逻辑:市场需求决

- 14883联想百应&长沙电信

- 14504数据中心行业购电协议(PP

- 14465如何计算和减少网络中的光纤

- 14396热化学储能在为数据中心供电

- 14187数据中心面临人员短缺和减少

- 14098什么是数据中心的交叉连接?

- 13969数据中心800G收发器市场

- 138910数据中心高温管理指南

推荐阅读

- 12-291数据中心机房设备布局规划

- 01-0522023年数据中心年度盘点

- 01-103数据中心是否尽可能实现碳中和?

- 01-114可持续技术:2024 年技术趋势

- 01-1752024年数据中心存储趋势

- 01-236什么是数据中心现代化?

- 01-247人工智能、5G和物联网如何刺激边

- 01-258数据中心有哪些物理安全威胁?

- 01-2692024年对数据中心及其基础设施

- 01-1610算力突围:打造AI浪潮下的坚实底

面向AI 2.0时代 Rambus发布HBM4控制器IP,开启TB级带宽

随着人工智能技术的飞速发展,尤其是大型语言模型(LLM)的兴起,对计算能力的需求呈现爆炸式增长。从GPT-3的1750亿参数到GPT-4的1.8万亿参数,短短几年内模型规模增长了400多倍,对内存带宽和容量提出了前所未有的挑战。面对AI 2.0时代的数据洪流,如何突破内存瓶颈,成为摆在整个行业面前的关键难题。

在这一背景下,Rambus 宣布推出业内首款HBM4内存控制器IP,旨在加速下一代AI工作负载,为AI 2.0时代的算力需求提供强劲的内存支持。Rambus研究员兼杰出发明家Steven Woo博士、Rambus 大中华区总经理苏雷先生会上接受了媒体采访,深入解读了HBM4控制器IP的特性、优势以及对AI产业发展的影响。

HBM4控制器IP:开启TB级带宽时代

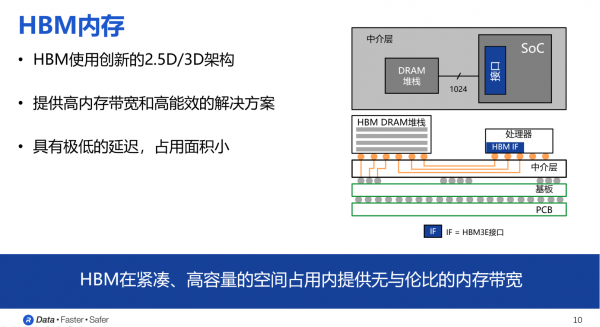

在AI训练过程中,海量数据的快速读写对内存带宽提出了极高的要求。HBM(高带宽内存)凭借其创新的2.5D/3D堆叠架构和高密度互连,能够提供更高的带宽、更低的延迟和更高的能效,成为AI训练硬件中不可或缺的关键技术。

“HBM内存非常适用于AI训练、高性能计算和网络应用,” Steven Woo博士表示,HBM具有非常高的带宽和密度,远高于市面上常见的普通DRAM。

Rambus研究员兼杰出发明家Steven Woo博士

然而,HBM的演进也面临着巨大的挑战。随着数据传输速率的不断提升,信号干扰、时序收敛以及与其他芯片的互操作性等问题日益突出。Rambus凭借其在高性能内存架构领域超过30年的经验积累,以及在HBM多个代际的成功客户实施经验,致力于解决这些技术难题,持续推动HBM技术的演进。

当前正处于应用阶段的HBM版本为HBM3E,JEDEC(固态技术协会,全球性标准组织)已经制定下一代HBM4的标准,相关技术与产品正处于研发阶段。

此次发布的HBM4控制器IP,是Rambus在HBM领域持续创新的最新成果。该控制器IP提供32个独立通道,总数据宽度达2048位,在6.4Gbps的数据速率下,总内存吞吐量可达1.64TB/s,比HBM3高出两倍以上,为AI 2.0时代的海量数据处理提供了强有力的支持。

除了更高的带宽,HBM4控制器IP还具备低延迟、高能效、模块化和高度可配置等优势,能够满足不同应用场景的定制化需求。此外,Rambus还提供了一系列补充工具,如测试平台和验证IP,以及与PHY供应商的紧密合作,确保客户能够轻松集成和验证整个解决方案,实现一次流片成功。

面向AI 2.0时代 携手共建AI生态

在AI 2.0时代,多模态、更强的生成能力等新特性对内存技术提出了更高的要求。Steven Woo博士认为,AI 2.0最主要的特征就是对内存带宽和容量需求的剧增:“Rambus HBM4控制器可以支持新一代HBM内存的部署,适用于最先进的处理器,包括AI加速器、图形处理器和高性能计算应用。”

Rambus不仅关注当前的市场需求,也着眼于未来的技术发展趋势。通过其研究机构Rambus Labs,Rambus不断探索如何改进未来的人工智能内存,包括如何提供更快的内存、更高的容量和更好的功耗效率,以满足AI产业不断增长的需求。

谈及未来的内存技术发展趋势,Steven Woo博士表示,更高的带宽和更大的容量将是未来内存技术发展的永恒主题,同时功耗效率的提升也是一个非常具有挑战性的领域,需要不断改进。

技术是Rambus不断创新和发展的基础,而要推动HBM技术的普及和应用,离不开与产业链上下游的紧密合作。Rambus积极与晶圆代工厂、PHY供应商以及芯片设计公司等合作伙伴携手,共同构建繁荣的AI生态系统。

通过与合作伙伴的紧密合作,Rambus不仅能够为客户提供完整的HBM子系统解决方案,还能够提供全方位的技术支持,帮助客户解决在产品设计、集成和验证过程中遇到的各种技术难题,缩短产品上市时间,并最终实现商业成功。

“我们非常注重售中和售后的服务,针对客户的项目产品规格、配置方面我们会在技术方面给予一些最佳的建议和参考” 苏雷先生表示,“Rambus可以帮助客户提前规避一些技术难题,并且更加快速地推出产品,为客户提供宝贵的产品附加值。”

Rambus 大中华区总经理苏雷先生

在AI 2.0时代,内存技术的发展将直接影响着AI产业的未来。Rambus凭借其在高性能内存领域的深厚技术积累和持续创新能力,以及与合作伙伴的紧密合作,将继续引领HBM技术的发展,为AI 2.0时代的算力需求提供强劲的内存支持,助力AI产业的蓬勃发展。

-

TOP