合作机构:阿里云 / 腾讯云 / 亚马逊云 / DreamHost / NameSilo / INWX / GODADDY / 百度统计

资讯热度排行榜

- 91131大模型×文本水印:清华、港

- 90392一文读懂如何基于 GenA

- 902632024 年,3 项技术将

- 89864利用人工智能增强网络安全防

- 89705GPT-4准确率最高飙升6

- 89676AI在工业物联网(IIoT

- 89627人工智能和机器学习在物联网

- 89608一句话让小姐姐为我换了N套

- 893492024年人工智能与数字孪

- 891810AI时代来了,专业摄影师会

推荐阅读

- 01-241技术趋势:2024年的热点是什么

- 01-252网络安全在自动驾驶汽车中的作用

- 01-253OpenAI创始人想打造全球芯片

- 01-264强化学习和世界模型中的因果推断

- 01-265Mamba论文为什么没被ICLR

- 01-296让知识图谱成为大模型的伴侣

- 01-297从20亿数据中学习物理世界,基于

- 01-298谷歌云与Hugging Face

- 01-299人工智能和机器学习在物联网中的作

- 01-2910无需人工标注!LLM加持文本嵌入

多智能体系统的合作之道:对MAS不确定性、社会机制与强化学习的探索

多智能体系统(MAS)是由多个自主智能体组成的系统,它们可以相互交互和协作,以完成一些共同或个人的目标。多智能体系统在许多领域都有广泛的应用,如机器人、交通、电力、社交网络等。但是如何促进智能体之间的合作行为一直是这一领域的难题,特别是在激励机制不确定的情况下。激励机制不确定是指智能体对于与其他智能体交互的收益和风险的认知存在不确定性,这可能导致智能体的行为偏离最优或最合理的选择,从而影响系统的整体效率和稳定性。

为了探索多智能体系统在激励机制不确定下的新兴合作,荷兰格罗宁根大学、阿姆斯特丹大学和布鲁塞尔自由大学的四位研究者在2024年的AAMAS会议上发表了一篇论文,题为《Emergent Cooperation under Uncertain Incentive Alignment》。这篇论文的创新点和价值在于:

1)提出一种基于扩展的公共物品游戏(EPGG)的实验框架,用来模拟多智能体系统在不同类型的游戏环境中的交互和学习,包括完全合作、完全竞争、混合动机和阈值四种情况。这种框架可以通过调节一个连续的乘法因子??来表示不同的激励对齐程度,从而覆盖了多智能体系统可能面临的各种场景。

2)引入一种高斯噪声的模型,用来模拟智能体对于乘法因子??的不确定性,即智能体观察到的??值是真实??值加上一个随机误差。这种模型可以反映智能体在真实世界中的信息不完全和不准确的情况,从而增加了实验的逼真度和复杂度。

3)探讨三种社会机制对于智能体合作行为的影响,分别是声誉机制、引导代理和内在奖励机制。声誉机制是指智能体根据自己和对手的行为和声誉来更新自己的声誉,从而影响自己的策略选择。引导代理是指一些固定的智能体,它们总是选择合作行为,并且对其他智能体的声誉有更大的影响。内在奖励机制是指智能体除了从环境中获得的奖励外,还会根据自己的行为和声誉获得一些额外的奖励,从而激励自己更加合作。

4)他们使用两种强化学习的算法,分别是Q-learning和DQN,来训练一组10个智能体在不同的游戏环境中进行多轮的EPGG游戏,并且分析了不同的社会机制对于智能体的平均合作率的影响。平均合作率是指智能体选择合作行为的平均相对频率,可以反映智能体的合作水平和倾向。

本文将对这篇论文的主要内容和结论进行解读和分析,帮助读者更好地理解多智能体系统在激励机制不确定下的新兴合作的问题和方法。

模型规则与特点

首先,我们来介绍一下扩展的公共物品游戏(EPGG)的基本规则和特点。EPGG是一种经典的博弈论模型,用来研究多个参与者之间的合作与背叛的问题。在EPGG中,每个参与者都有一个固定的财富??,他们可以选择将一部分或全部的财富投入到一个公共池中,或者保留自己的财富不投入。然后公共池中的财富会被乘以一个乘法因子??,再平均分配给所有的参与者。乘法因子??可以反映公共物品的生产效率和价值,它的大小决定了游戏的性质。如果??大于参与者的人数??,那么游戏是合作的,即所有人都投入全部财富是最优的策略。如果??小于1,那么游戏是竞争的,即所有人都不投入任何财富是最优的策略。如果??在1和??之间,那么游戏是混合动机的,即存在多个均衡,而且每个人的最优策略取决于其他人的策略。如果??等于1或??,那么游戏是阈值的,即任何策略都是均衡,而且每个人的收益都相同。

图1:配置文件的条目??和??(????) 是指标函数,如果代理的动作,则等于1??是合作的,否则为0,并且????表示???第个条目共??. 因为我们假设1<?? < ??, 很容易检验,在PGG中,所有代理叛逃的配置文件是一个主导策略平衡,而Pareto最优配置文件是所有代理合作的配置文件。这反映了PGG的社会困境本质。特别是对于?? = 2 PGG定义了一类囚犯困境游戏。

在论文中作者使用了扩展的EPGG模型,它有以下几个特点:

使用一个连续的乘法因子??,而不是离散的几个值,这样可以覆盖更多的游戏环境,也可以增加游戏的难度和复杂度。

使用高斯噪声的模型,来模拟智能体对于乘法因子??的不确定性,即智能体观察到的??值是真实??值加上一个随机误差。这种模型可以反映智能体在真实世界中的信息不完全和不准确的情况,也可以考察智能体如何在不确定的环境中做出决策。

使用一个声誉机制来模拟智能体之间的信任和评价,即智能体根据自己和对手的行为和声誉来更新自己的声誉,从而影响自己的策略选择。声誉机制可以反映智能体之间的社会规范和影响,也可以激励智能体更加合作。

使用了一个内在奖励机制来模拟智能体的自我激励和满足,即智能体除了从环境中获得的奖励外,还会根据自己的行为和声誉获得一些额外的奖励,从而激励自己更加合作。内在奖励机制的具体实现是这样的,智能体会维护一个自己的声誉值,初始为0,每次与其他智能体交互后,根据自己和对方的行为,更新自己的声誉值。如果自己选择合作,声誉值增加1;如果自己选择背叛,声誉值减少1;如果对方选择合作,声誉值不变;如果对方选择背叛,声誉值减少2。声誉值的范围是[-10, 10],如果超过这个范围,就截断为边界值。智能体的内在奖励就是自己的声誉值乘以一个系数??,??是一个正的超参数,用来控制内在奖励的强度。智能体的总奖励就是外在奖励和内在奖励的和。

训练过程

接下来我们来看一下作者使用Q-learning和DQN算法训练智能体的具体过程和结果。Q-learning是一种基于表格的强化学习算法,它可以让智能体通过不断地尝试和反馈,学习到一个动作值函数,即每个状态和动作对应的期望收益。DQN是一种基于神经网络的强化学习算法,它可以让智能体通过不断地观察和学习,近似地拟合一个动作值函数,从而适应更复杂和高维的状态空间。作者使用了这两种算法,来比较它们在不同的游戏环境和社会机制下的表现和差异。

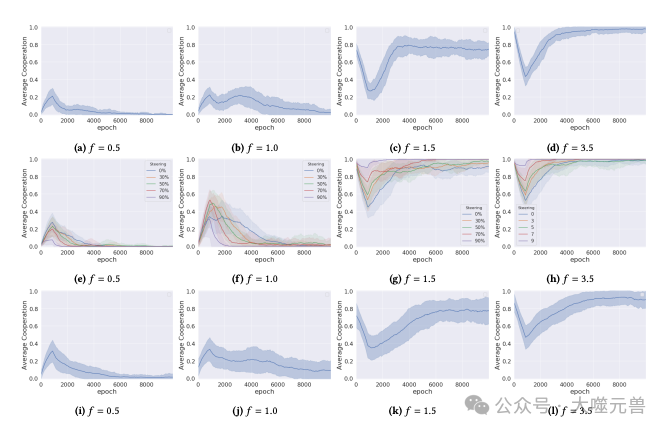

图2:在不同倍增因子的环境中训练的DQN代理的平均合作。最上面一行(a-d)显示了在没有合作辅助机制的情况下的结果,中间一行(e-h)显示了存在声誉机制和有助于合作的社会规范的情况,最下面一行(i-l)显示了有内在奖励的情况。

作者首先在没有不确定性的情况下,使用Q-learning算法训练智能体,观察它们在不同的乘法因子??下的平均合作率。作者发现,当?? = 0.5时,智能体的平均合作率接近于0,即智能体几乎都选择背叛行为,这与理论上的最优策略一致。当?? = 1.0时,智能体的平均合作率略高于0,即智能体偶尔会选择合作行为,这可能是由于智能体的探索行为或者学习的不完全导致的。当?? = 1.5时,智能体的平均合作率达到了0.78,即智能体大部分时候会选择合作行为,这表明智能体能够在混合动机的游戏中实现合作的均衡。当?? = 3.5时,智能体的平均合作率接近于1,即智能体几乎都选择合作行为,这也与理论上的最优策略一致。

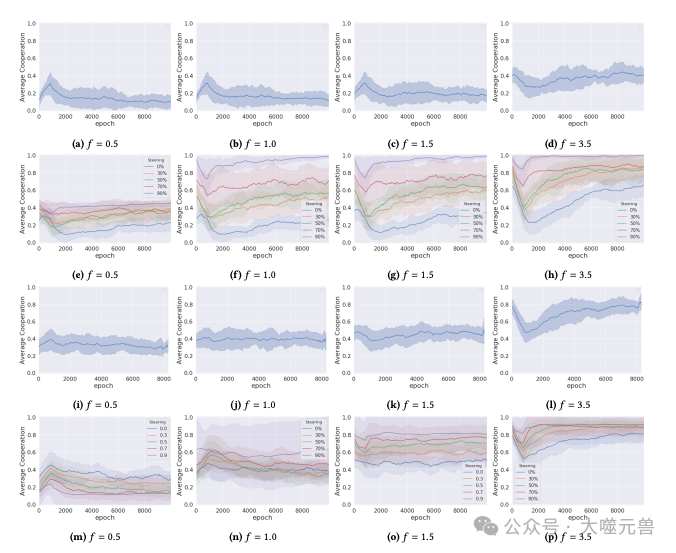

作者在引入不确定性的情况下,使用DQN算法训练智能体,观察它们在不同的乘法因子??下的平均合作率。作者发现,当?? = 0.5时,智能体的平均合作率略高于0.1,即智能体偶尔会选择合作行为,这可能是由于不确定性的影响,使得智能体对于背叛的收益不太确定。当?? = 1.0时,智能体的平均合作率略高于0.1,即智能体偶尔会选择合作行为,这与Q-learning的结果相似。当?? = 1.5时,智能体的平均合作率降低到了0.16,即智能体大部分时候会选择背叛行为,这表明不确定性对于混合动机的游戏有很大的负面影响,使得智能体无法达成合作的均衡。当?? = 3.5时,智能体的平均合作率降低到了0.4,即智能体只有一半的概率会选择合作行为,这表明不确定性也对于合作的游戏有一定的负面影响,使得智能体无法达到最优的策略。

作者在引入声誉机制的情况下,使用DQN算法训练智能体,观察它们在不同的乘法因子??下的平均合作率。作者发现,当?? = 0.5时,智能体的平均合作率略高于0.2,即智能体偶尔会选择合作行为,这与没有声誉机制的情况相似。当?? = 1.0时,智能体的平均合作率略高于0.2,即智能体偶尔会选择合作行为,这与没有声誉机制的情况相似。当?? = 1.5时,智能体的平均合作率提高到了0.33,即智能体有一定的概率会选择合作行为,这表明声誉机制对于混合动机的游戏有一定的正面影响,使得智能体能够识别和合作有利的伙伴。当?? = 3.5时,智能体的平均合作率提高到了0.65,即智能体大部分时候会选择合作行为,这表明声誉机制对于合作的游戏有很大的正面影响,使得智能体能够达到接近最优的策略。

图3:在不确定性条件下,在具有不同倍增因子的环境中训练的DQN代理的平均合作(???? = 2 ??? ∈ ??). 结果显示在四行中:第一行没有声誉或内在奖励,第二行有声誉和有助于合作的社会规范,第三行有内在奖励公式,第四行有声誉、有助于协作的社会规范和内在奖励公式。

最后作者在引入内在奖励机制的情况下,使用DQN算法训练智能体,观察它们在不同的乘法因子??下的平均合作率。作者发现,当?? = 0.5时,智能体的平均合作率提高到了0.31,即智能体有一定的概率会选择合作行为,这表明内在奖励机制对于竞争的游戏有一定的正面影响,使得智能体能够获得更多的满足感。当?? = 1.0时,智能体的平均合作率提高到了0.36,即智能体有一定的概率会选择合作行为,这表明内在奖励机制对于阈值的游戏有一定的正面影响,使得智能体能够获得更多的满足感。当?? = 1.5时,智能体的平均合作率降低到了0.45,即智能体只有一半的概率会选择合作行为,这表明内在奖励机制对于混合动机的游戏有一定的负面影响,使得智能体更倾向于自我博弈而不是与其他智能体合作。当?? = 3.5时,智能体的平均合作率提高到了0.78,即智能体大部分时候会选择合作行为,这表明内在奖励机制对于合作的游戏有一定的正面影响,使得智能体能够获得更多的满足感。

实验结论

通过上述的实验结果,我们可以得出以下的结论和观点。

不确定性对于智能体的合作行为有很大的负面影响,特别是在混合动机和合作的游戏中,使得智能体无法达成合作的均衡或最优的策略。这可能是因为不确定性增加了智能体的风险和不信任,使得智能体更难以判断其他智能体的行为和意图,从而更倾向于选择保守或自私的行为。

声誉机制对于智能体的合作行为有很大的正面影响,特别是在混合动机和合作的游戏中,使得智能体能够识别和合作有利的伙伴。这可能是因为声誉机制增加了智能体的信任和评价,使得智能体更容易判断其他智能体的行为和意图,从而更倾向于选择合作或互惠的行为。

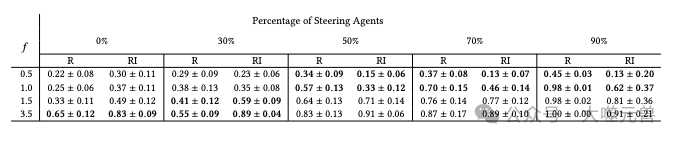

图4:每场比赛的合作平均值和标准差,是过去 50 个训练周期的平均值具有不确定性的实验。这些措施针对两种情况分别报告:一种情况是只有声誉启用机制(R)以及同时采用声誉机制和内在奖励的机制(RI)。价值观表现出统计显着性的内容以粗体显示。

内在奖励机制对于智能体的合作行为有不同的影响,取决于游戏的性质和其他社会机制的存在。在竞争和阈值的游戏中,内在奖励机制可以提高智能体的合作行为,因为智能体可以从合作中获得更多的满足感,而不用担心损失太多的收益。在混合动机的游戏中,内在奖励机制可以降低智能体的合作行为,因为智能体可能会过分地追求自我满足,而忽视了其他智能体的利益和反馈。在合作的游戏中,内在奖励机制可以提高智能体的合作行为,因为智能体可以从合作中获得更多的满足感,而且与其他智能体的利益和反馈是一致的。当声誉机制和引导代理也存在时,内在奖励机制可以与之相互补充,使得智能体在不同的游戏环境中更容易达成合作或背叛。

Q-learning和DQN算法在不同的游戏环境和社会机制下的表现和差异不是本文的重点,但是可以从实验结果中观察到一些有趣的现象。例如,Q-learning算法在没有不确定性的情况下,可以更好地学习到最优的策略,而DQN算法在有不确定性的情况下,可以更好地适应更复杂和高维的状态空间。另外,Q-learning算法在混合动机的游戏中,可以达到更高的平均合作率,而DQN算法在合作的游戏中,可以达到更高的平均合作率。这些现象可能与算法的特性和参数的选择有关,也可能与实验的设置和随机性有关,需要进一步的研究和验证。

总结与展望

论文的主要贡献是提出了一种基于扩展的公共物品游戏(EPGG)的实验框架,用来模拟多智能体系统在不同类型的游戏环境中的交互和学习,以及探讨了三种社会机制(声誉机制、引导代理和内在奖励机制)对于智能体合作行为的影响,特别是在激励机制不确定的情况下。本文的实验结果表明,不确定性对于智能体的合作行为有很大的负面影响,而社会机制可以在不同的游戏环境中产生不同的效果,有时可以相互补充,有时可以相互抵消。作者的研究为多智能体系统的合作问题提供了一种新的视角和方法,也为未来的研究提供了一些启示和方向。

未来的研究可以从环境、算法、机制等方面进行拓展和深入。在更多的游戏环境中进行实验,例如考虑更多的参与者、更复杂的动作空间、更多的信息维度等,以检验本文的实验框架和社会机制的普适性和有效性。在更多的强化学习的算法中进行实验,例如考虑更先进的算法、更多的超参数、更多的网络结构等,以比较不同的算法在不同的游戏环境和社会机制下的表现和差异。在更多的社会机制中进行实验,例如考虑更多的声誉更新规则、更多的引导代理的比例和策略、更多的内在奖励的形式等,以探索不同的社会机制对于智能体合作行为的影响和机理。在更多的通信和协调机制中进行实验,例如考虑智能体之间的语言交流、信号传递、合作协议等,以研究通信和协调机制如何与社会机制相互作用,以及如何促进智能体之间的合作和信任。

论文的研究为多智能体系统的合作问题提供了一种新的视角和方法,也为未来的研究提供了一些启示和方向。我们希望该论文能够引起读者的兴趣和关注,也期待更多的研究者和实践者能够参与到这一有趣和有意义的领域中来,共同探索多智能体系统在激励机制不确定下的新兴合作的奥秘和可能。(END)

参考资料:https://arxiv.org/abs/2401.12646

-

TOP