合作机构:阿里云 / 腾讯云 / 亚马逊云 / DreamHost / NameSilo / INWX / GODADDY / 百度统计

资讯热度排行榜

- 91131大模型×文本水印:清华、港

- 90392一文读懂如何基于 GenA

- 902632024 年,3 项技术将

- 89864利用人工智能增强网络安全防

- 89705GPT-4准确率最高飙升6

- 89676AI在工业物联网(IIoT

- 89627人工智能和机器学习在物联网

- 89608一句话让小姐姐为我换了N套

- 893492024年人工智能与数字孪

- 891810AI时代来了,专业摄影师会

推荐阅读

- 01-241技术趋势:2024年的热点是什么

- 01-252网络安全在自动驾驶汽车中的作用

- 01-253OpenAI创始人想打造全球芯片

- 01-264强化学习和世界模型中的因果推断

- 01-265Mamba论文为什么没被ICLR

- 01-296让知识图谱成为大模型的伴侣

- 01-297从20亿数据中学习物理世界,基于

- 01-298谷歌云与Hugging Face

- 01-299人工智能和机器学习在物联网中的作

- 01-2910无需人工标注!LLM加持文本嵌入

英伟达Jim Fan最新TED演讲上线:AI下一个前沿是「基础智能体」!

「AI的下一个前沿将是『基础智能体』(Foundation Agent)——一个掌握广泛技能,控制许多身体,并能够泛化到多个环境中的单一算法」。

等了三个月,英伟达高级科学家Jim Fan在TED AI 2023上的演讲视频终于上线了。

视频中,Jim Fan提出了「Foundation Agent」,一个可以在虚拟世界和现实世界里泛化的通用智能体模型。

他具体解释了,这项技术将如何从根本上改变我们的生活,进入到从视频游戏和元宇宙,到无人机、仿人机器人的方方面面,并探讨了单一模型如何掌握跨越这些不同现实的技能。

Jim Fan认为,「基础智能体」应该在3个维度上进行扩展:

- 技能:能解决的任务数量;

- 具身:能控制的身体形态的多样性;

- 现实:智能体能掌握的虚拟或物理空间的数量。这包括有不同规则的游戏、模拟和真实世界场景。

我们为什么想要一个单一的「基础智能体」,而不是许多更小的模型?

在每个AI领域的发展历史中,都能发现这样模式:从专家模型 -> 通用模型 -> 专业化的通用模型。

这里的「专业化的通用模型」通常远比原先的专家模型更强大,就像 LlaMA 的精炼版本远超过5年前的定制化NLP系统一样。

此外,Jim Fan本人还分享了演讲时的心得。

「在TED演讲时,我脚下只有一个「信心」显示器,只显示当前的幻灯片和计时器。这意味着我需要完全记住整段演讲。一开始让我很担心,但事实证明,这是与听众建立联系,直接触及他们心灵的最佳方式」。

值得一提的是,Jim Fan还公开了这次演讲的PPT,一起看看这场演讲的精彩亮点吧。

TED演讲全文

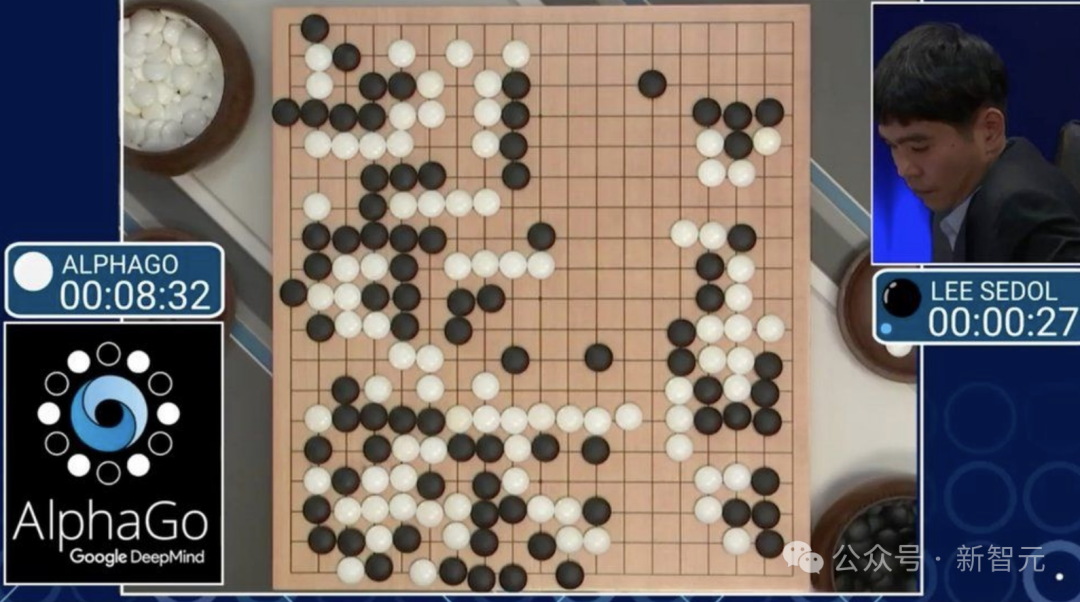

2016年的春天,我坐在哥伦比亚大学的一间教室里,并没有专心听讲。相反,我正用电脑观看一场棋盘游戏锦标赛。

这不是一场普通的比赛,而是一场非常、非常特别的比赛——AlphaGo与李世石开启对决。

这场比赛,AI在五盘棋中赢了三盘,成为有史以来第一个在围棋比赛中击败人类冠军的「棋手」。

到现在,我仍然记得那天自己见证历史的激动心情。AI智能体终于进入主流的时刻。

但当兴奋褪去后,我意识到,AlphaGo虽然强大,但它只能做一件事,而且只能做一件事。

它无法玩任何其他游戏,比如《超级马里奥》、《我的世界》,当然也不能帮你洗脏衣服,或今晚为你做一顿丰盛的晚餐。

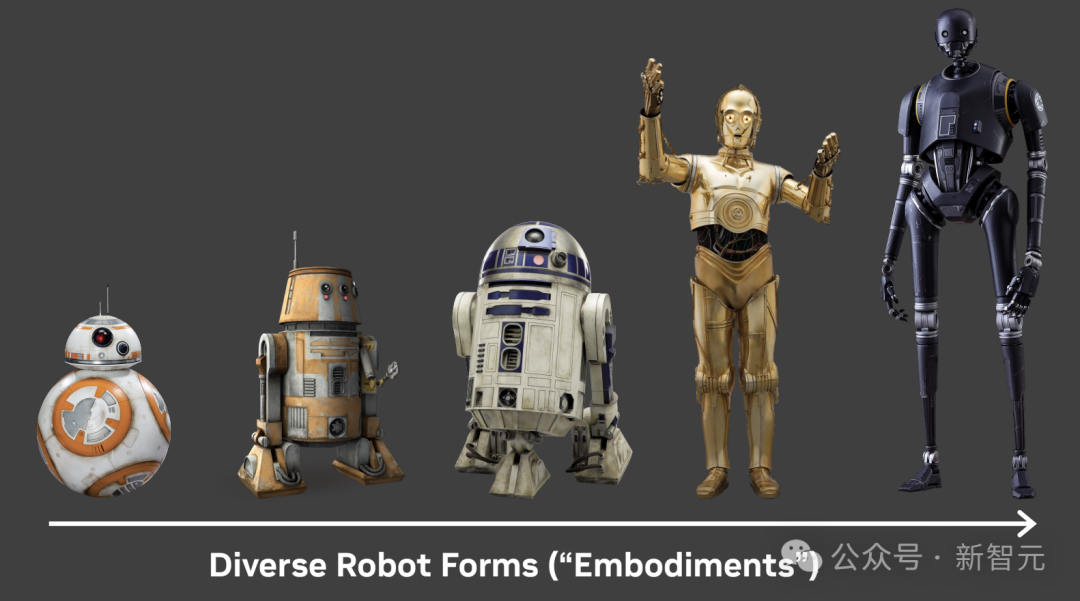

我们真正想要的是:像机器人Wall-E那样多才多艺的AI智能体,像《星球大战》中的各种各样机器人的载体或化身。

又或是像《头号玩家》一样,可以跨越无限的虚拟或现实世界。

那么我们如何在不久的将来实现这些科幻想法呢?

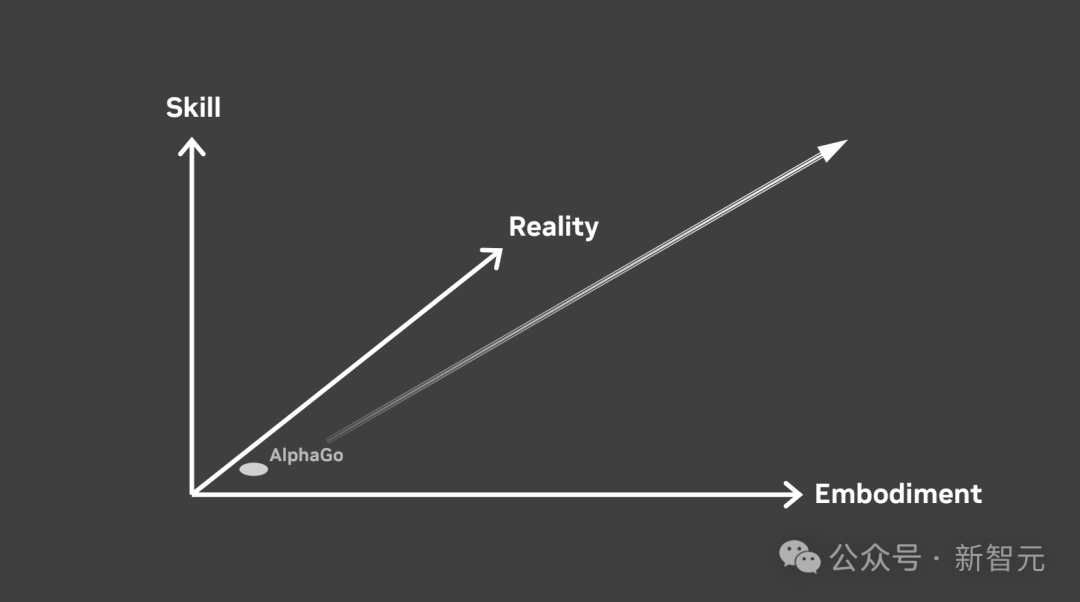

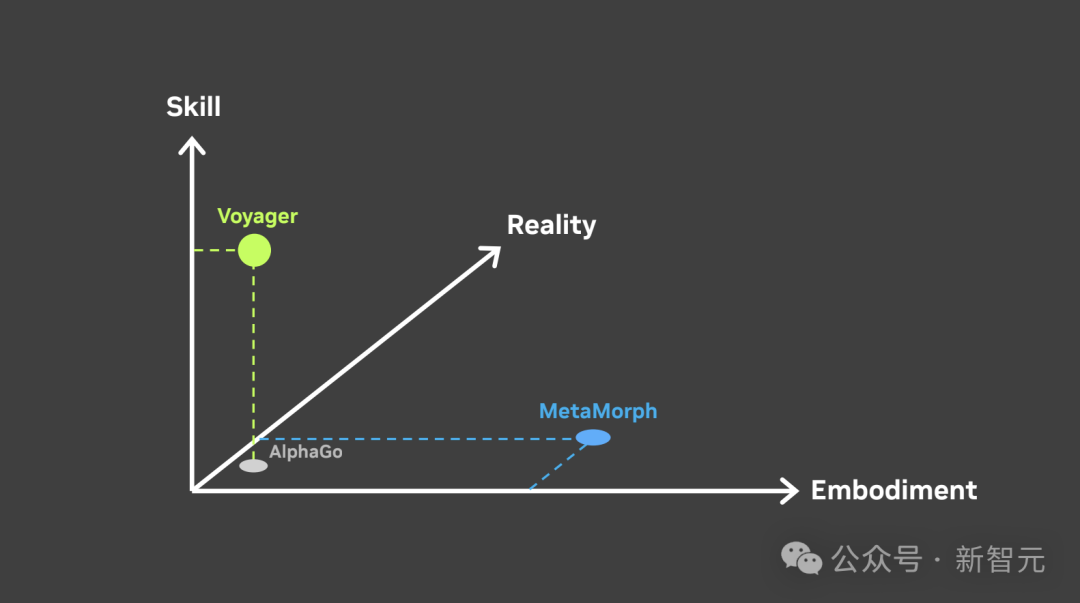

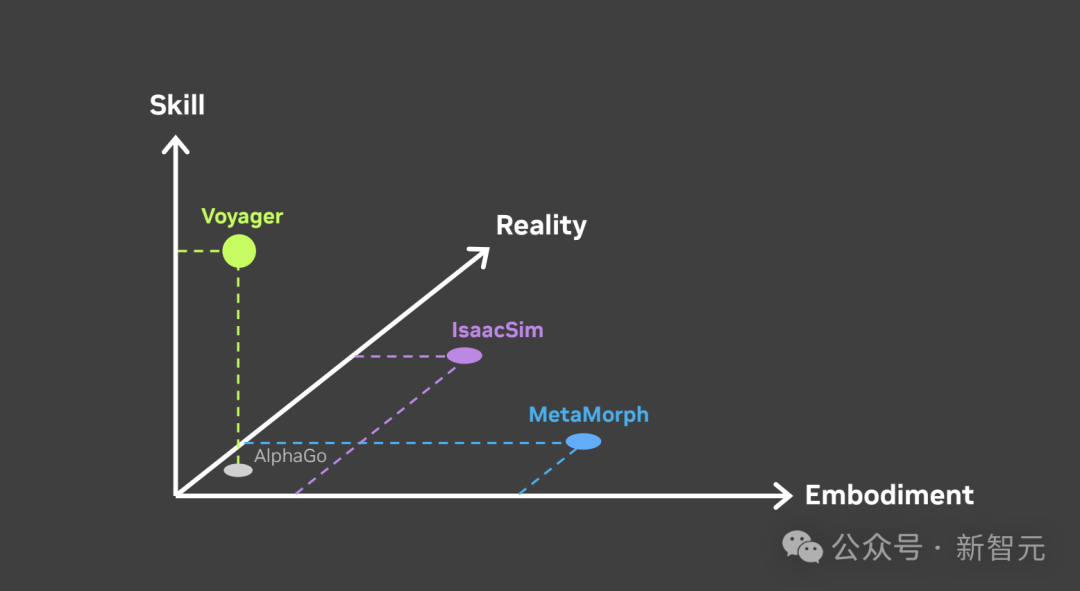

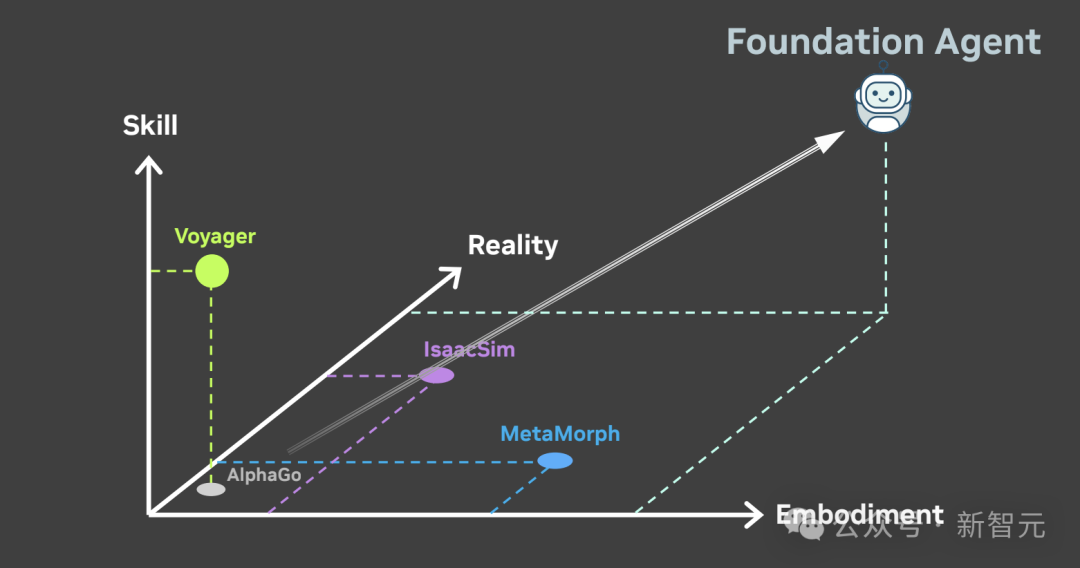

如下左图是迈向通用AI智能体的一个实践者指南。当前的大多数研究工作按以下三个维度展开:

AI智能体可以掌握的技能数量;可以控制的身体形态或载体;以及它所能掌握的现实情况。AlphaGo就在左下角的位置,但右上角才是我们真正要达到的目标。

Voyager玩转「我的世界」

接下来,让我们一次看一个维度。

今年早些时候,我带领了「Voyager」项目,这是一个能在多种技能上大规模扩展的智能体。没有任何游戏能比《我的世界》更好地支持无限的创造性玩法。

这有一个有趣的事实:《我的世界》现在有1.4亿活跃玩家。这个数字相当于英国人口的2倍多。

这款游戏之所以如此受欢迎,是因为它是开放式的:没有固定的游戏情节,你可以在游戏中做任何想做的事情。

当我们让Voyager在《我的世界》中自由活动时,会发现它可以在没有任何人干预的情况下,连续玩上几个小时的游戏。

这段视频展示了Voyager在一次游戏中连续行动的片段。

它可以探索地形,开采各种材料,与怪物战斗,制作数百种配方,并解锁一个不断扩展的技能树。

那么,其中的奥妙是什么呢?核心要义是「编码即行动」。

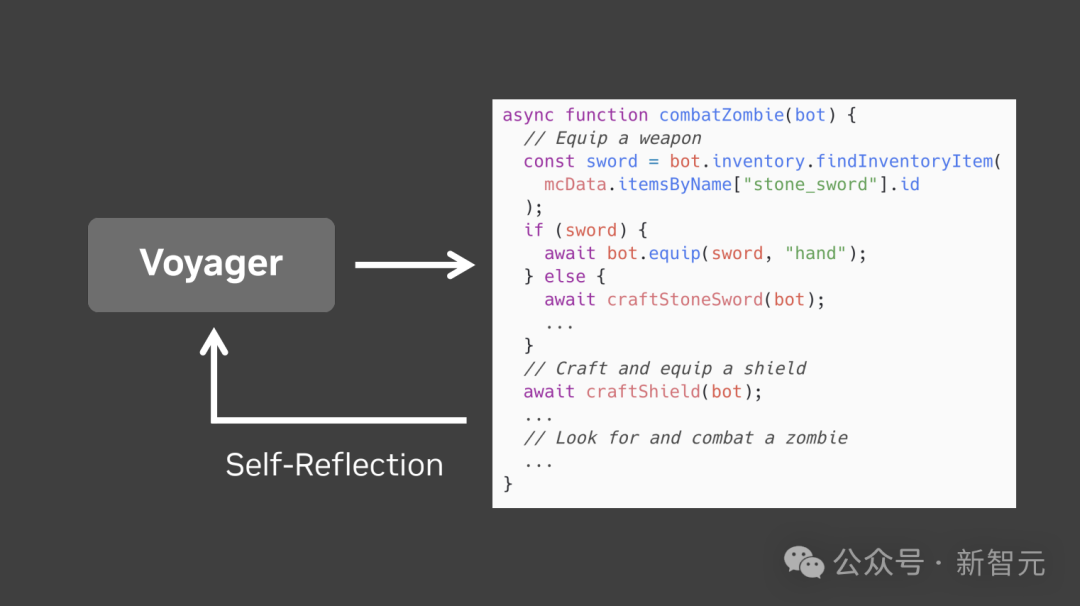

首先,我们使用社区制作的Minecraft JavaScript API将3D世界转换为文本表示。Voyager调用GPT-4,用JavaScript编写代码片段,这些代码片段将成为游戏中的可执行技能。

然而,就像人类工程师一样,Voyager也会犯错。它并不总是在第一次尝试时,就正确地完成程序。

因此,我们为它添加了一个「自我反思」机制,以便改进。

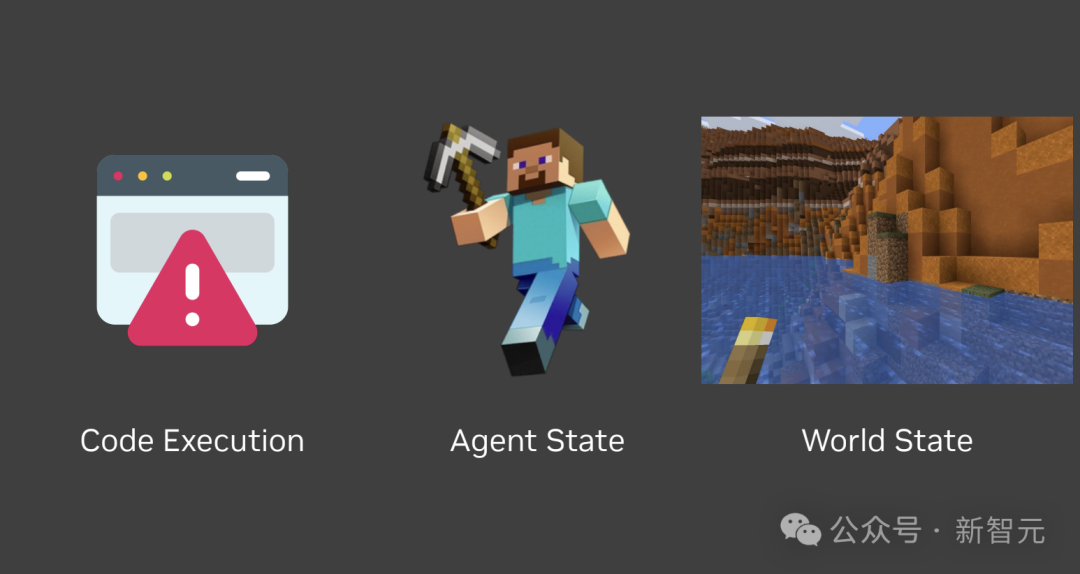

「自我反思」有三个反馈来源:JavaScript代码执行错误;智能体状态,如健康和饥饿;以及世界状态,如附近的地形和敌人。

因此,Voyager会执行一个动作,观察这个动作对世界和自身的影响,反思如何才能做得更好,并尝试一些新的行动方案,然后不断重复。

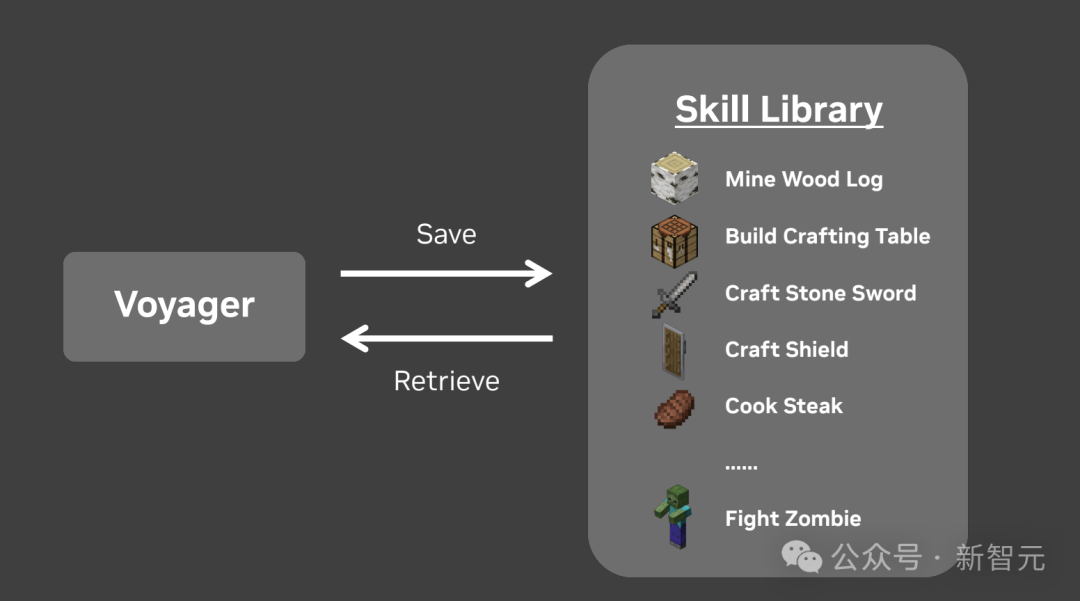

一旦技能成熟,Voyager就会把它保存到技能库中,作为一种持久的记忆。

你可以把技能库看作一个完全由语言模型编写的代码库。

通过这种方式,Voyager在《我的世界》中探索和实验过程中,能够以递归的方式扩展自身的能力。

让我们一起看个例子。

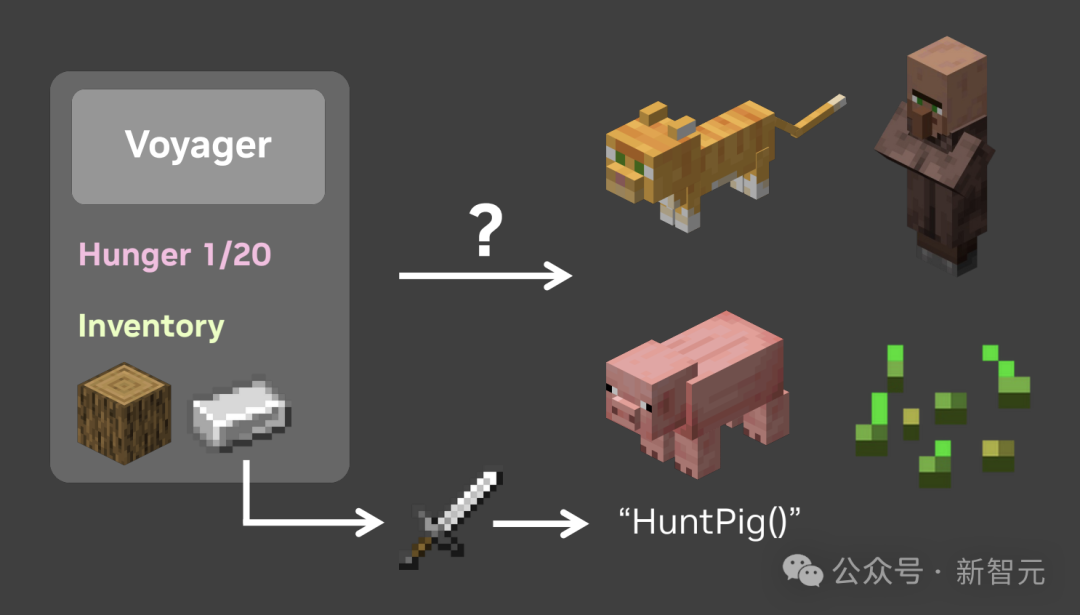

Voyager发现自己很饿,需要尽快获得食物。它检测到附近有四个实体:一只猫、一个村民、一头猪和一些小麦种子。

Voyager开始了内心独白:「我要杀死猫,还是村民来获取食物?这主意糟透了。小麦种子如何?我可以用种子种植农场,但那需要很长时间。对不起,小猪,你被选中了」。

随后,Voyager在它的物品栏中发现了一块铁。

于是,它从技能库中回想起了一个旧技能来制作铁剑,并开始学习一个新技能「猎猪」。现在我们也知道,不幸的是,Voyager不是素食主义者。

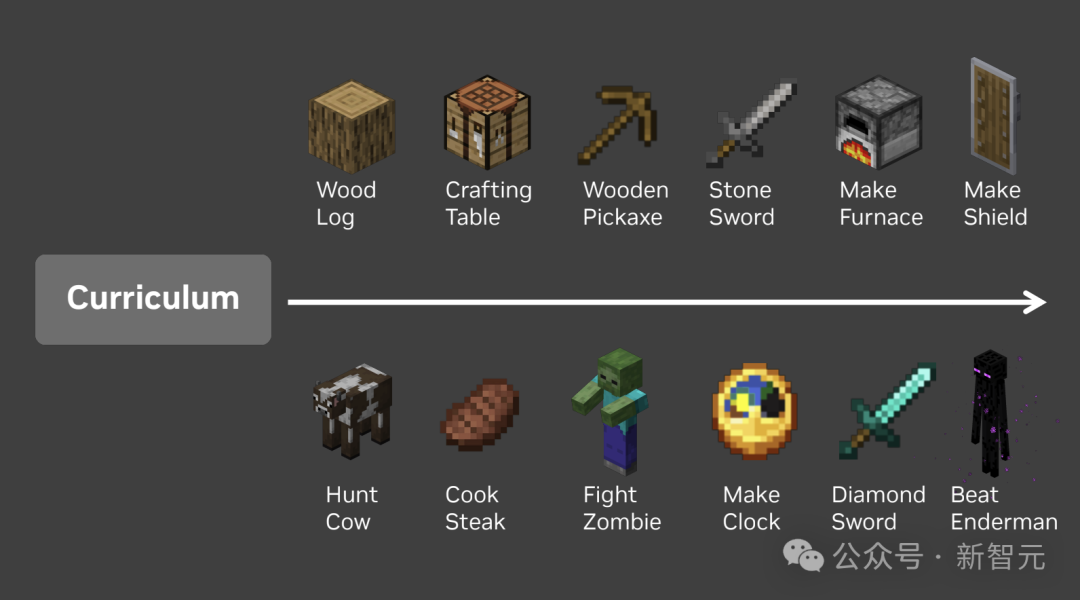

还有一个问题:Voyager如何无限期地探索下去?

我们只给了它一个高级指令,那就是尽可能多地获取独一无二的物品。

Voyager自己实现了一个curriculum:主动找到逐步更难、更新颖的挑战来解决。

将所有这些整合在一起,Voyager不仅能掌握,还能在过程中发现新的技能。而我们没有预先编程任何内容,一切都是Voyager的主意。

当一个智能体永远充满好奇心,永远追求新的探险,这就是我们所说的终身学习。与AlphaGo相比,Voyager能做的事情非常多,但仍只能在《我的世界》中控制一个身体。

MetaMorph让AI有多个身体

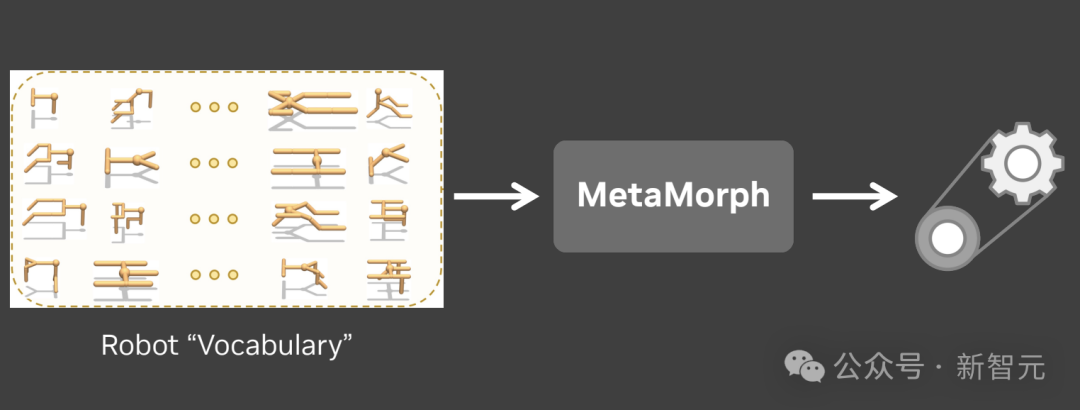

那么问题来了:我们能否有一个可以在不同载体上工作的算法?一起来看MetaMorph,这是我在斯坦福共同开发的一个项目。

我们创建了一个基础模型,它不仅能控制一个机器人,还能控制数千个手臂和腿部配置各异的机器人。

Metamorph能够处理来自不同机器人身体的各种运动特征。

如下我们如何创建MetaMorph的直观方法。首先,我们设计一个特殊的词来描述身体部件,这样每个机器人本质上就是用这种词写成的一句话。

然后,我们对其应用Transformer,就像ChatGPT一样,但MetaMorph写出的不是文本,而是运动控制。

我们展示了MetaMorph能够控制成千上万个机器人上下楼梯、穿越复杂地形,避开障碍物。

放眼未来,如果我们可以大大扩展这个机器人词汇量,我设想MetaMorph 2.0将能够泛化到机器手、人形机器人、狗、无人机甚至更多领域。

与Voyager相比,MetaMorph在多体控制方面迈出了一大步。

不同虚拟环境模拟

现在,让我们将一切再提升一个层次,在不同的环境之间转移技能和载体。来看IsaacSim,这是英伟达的模拟平台。

IsaacSim最大的优势是,将物理模拟加速到比实时快1000倍。

例如,这个小人只用了3天的模拟时间,就通过10年的高强度训练,学会了令人印象深刻的武术。

而这个赛车场景则是,仿真技术跨过「恐怖谷」的地方。

多亏了硬件加速光线追踪技术,我们才能渲染出极其复杂的场景,并呈现出令人叹为观止的细节。

你在这里看到的逼真效果将帮助我们训练计算机视觉模型,这些模型将成为每个人工智能智能体的眼睛。

更重要的是,IsaacSim可以程序化地生成具有无限变化的世界,因此没有两个世界看起来是一样的。

这里有一个有趣的想法。

如果一个智能体能够掌握10000个模拟,那么它很有可能会泛化到真实物理世界,因为我们的世界也只是第10001个「实境」。让我们沉浸其中吧。

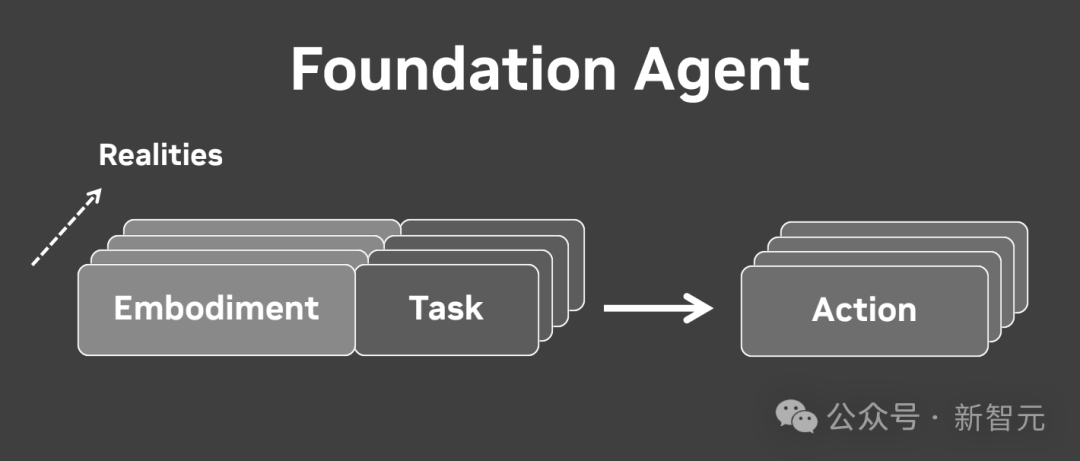

随着我们在这张图上的进展,我们最终会到达右上角,那是一个能在所有三个轴上进行泛化的单一智能体,那就是「基础智能体」。

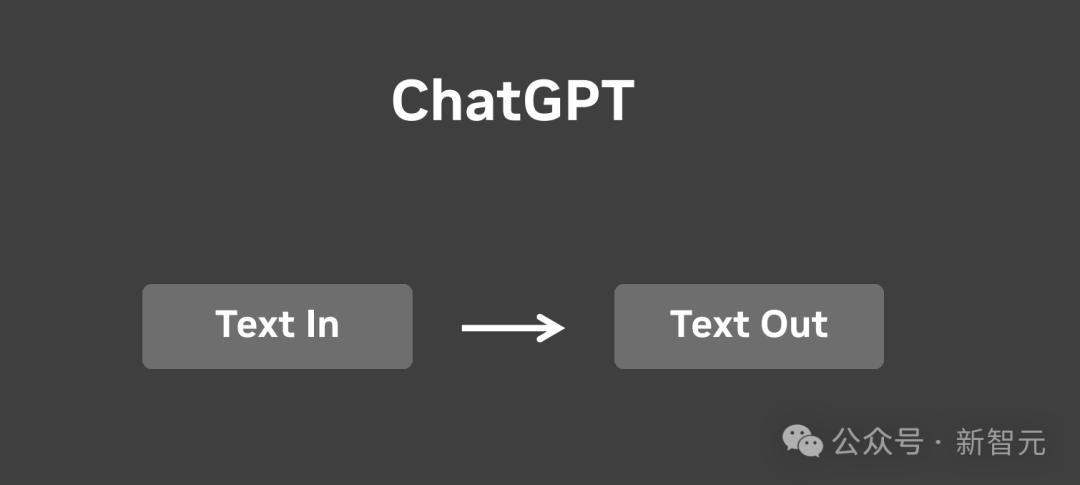

我相信,基础智能体的训练将与ChatGPT非常相似。

所有语言任务都可以表达为文本输入和文本输出。无论是写诗、将英语翻译成西班牙语还是编写Python代码,都是一样的。

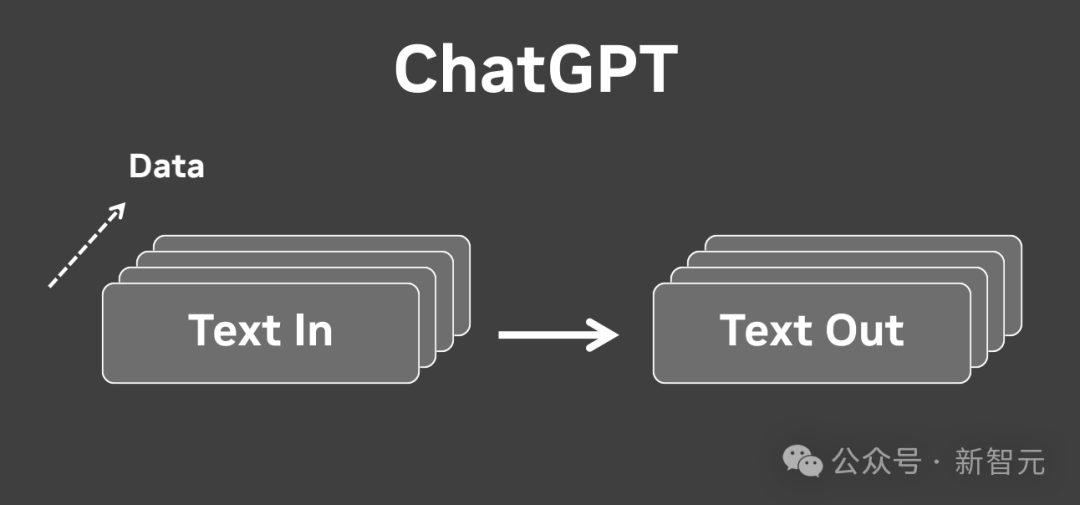

而ChatGPT只需在大量数据中进行大规模扩展即可。

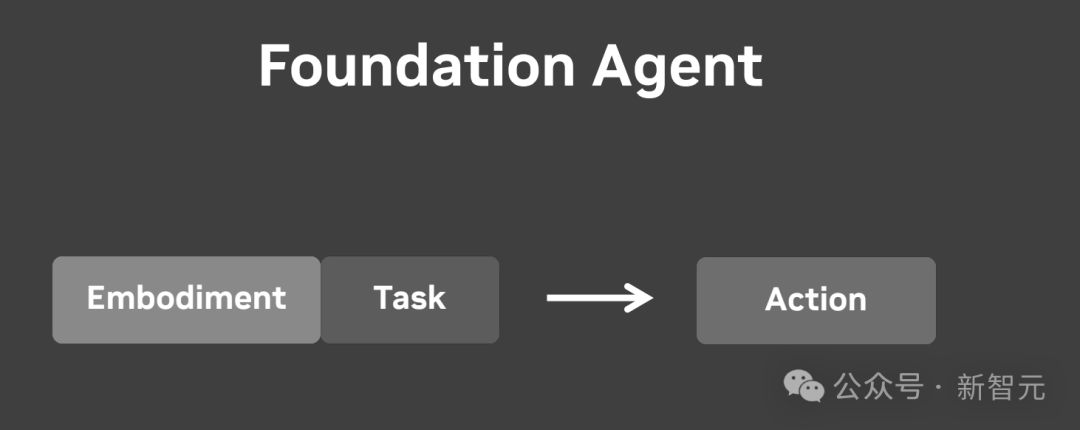

原理一样。基础智能体将任务提示作为输入,并输出操作。

我们只需在大量现实数据中对其进行大规模扩展,即可对其进行训练。

我相信在未来,一切能够移动的东西最终都将是自主的。

有一天我们会发现,所有的AI智能体,无论是《Wall-E》、《星球大战》,还是《头号玩家》。

无论是在物理空间还是虚拟空间,对于同一个基础智能体来说都只是不同的提示。

朋友们,这将是我们探索人工智能的下一个巨大挑战。

-

TOP